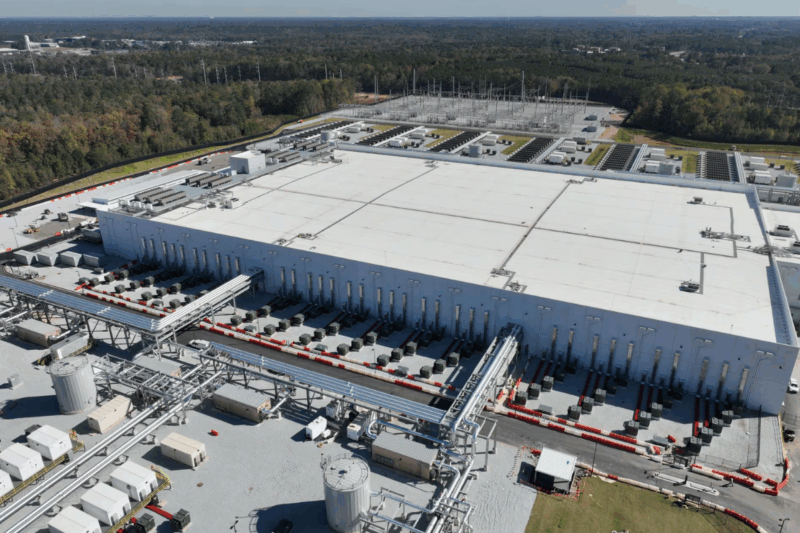

À Atlanta, un nouveau site hypermoderne s’apprête à changer l’échelle du calcul mondial.

Microsoft vient d’y présenter Fairwater, sa future « super-usine » dédiée à l’IA, conçue pour fonctionner de manière unifiée avec ses infrastructures existantes, notamment le site jumeau déjà opérationnel dans le Wisconsin.

Voir cette publication sur Instagram

Une manière d’assembler, pièce par pièce, un vaste supercalculateur réparti sur plusieurs régions du globe.

Un chantier qui rebat les cartes du calcul massif

Depuis plusieurs années, la firme de Redmond réinvente la manière de bâtir des datacenters pensés pour l’intelligence artificielle, portée notamment par les besoins croissants d’entraînement de modèles géants.

Avec Fairwater, elle dévoile une architecture entièrement repensée autour d’un réseau ultra-plat et de GPU organisés en densité extrême.

Today, we’re unveiling the next Fairwater AI datacenter in Atlanta—powering the world’s first planet-scale AI superfactory.

Built with breakthroughs in compute density, sustainability, and networking to efficiently meet unprecedented AI demand. pic.twitter.com/vhVcEz3ET3

— Microsoft Azure (@Azure) November 12, 2025

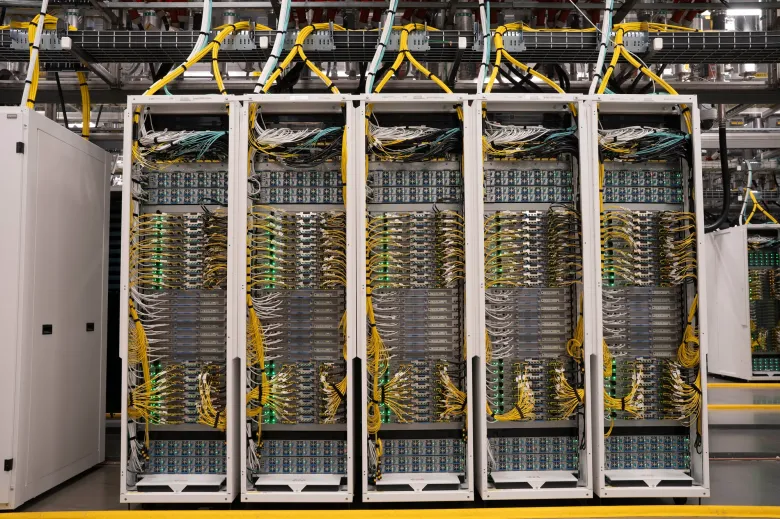

Au cœur du dispositif : des centaines de milliers de GPU NVIDIA Blackwell (GB200 et GB300), coordonnés comme un seul système.

Une orientation qui traduit une ambition claire : s’adapter à l’explosion des demandes en pré-entraînement, en inférence ou en génération de données synthétiques.

Ce qui différencie la nouvelle génération Azure AI

Microsoft détaille plusieurs innovations clés qui distinguent cette architecture des centres de données traditionnels :

- Densité GPU extrême : une organisation sur-mesure pour limiter la latence entre processeurs et optimiser le dialogue GPU-à-GPU.

- Refroidissement liquide fermé : un circuit étanche réutilisant la même eau pendant plus de six ans.

- Puissance énergétique massive : jusqu’à 1,36 MW par rangée.

- Réseau Ethernet à large bande passante : connectivité à 800 Gbit/s pour fluidifier la circulation des données.

- Optimisation réseau temps réel : réduction et pulvérisation intelligente des paquets, équilibrage avancé.

- Toile IA planétaire : les différents sites sont reliés par une dorsale optique à faible latence, créant un supercalculateur global.

- Modèle énergétique résilient : ajusté aux réseaux locaux, avec tampons d’énergie pour absorber les pics d’activité.

Autrement dit, Fairwater n’est pas seulement un nouveau datacenter : c’est une brique dans une architecture distribuée, pensée pour évoluer au rythme des modèles de plus en plus gourmands.

Ce que cela change pour les équipes d’IA

Pour les chercheurs et ingénieurs, cette unification des infrastructures promet une flexibilité nouvelle.

Les mêmes serveurs pourront gérer aussi bien le pré-entraînement que le réglage fin ou l’apprentissage par renforcement, sans basculer d’une architecture à l’autre.

Une vision tournée vers l’avenir

L’annonce intervient alors que les besoins en calcul explosent, poussés par les modèles multimodaux et la course à l’IA générative.

En reliant entre eux plusieurs continents via une dorsale optique dédiée, Microsoft semble parier sur une idée simple : le futur de l’IA se jouera dans l’interconnexion, la densité et l’optimisation énergétique.

Reste à voir comment l’écosystème cloud répondra à cette accélération.

Une chose est sûre : Fairwater s’inscrit dans une stratégie où l’infrastructure devient un avantage compétitif aussi déterminant que les modèles eux-mêmes.

Leave a reply

Vous devez vous connecter pour publier un commentaire.